Grandes modelos de idiomas se destacam em criar e resolver testes de inteligência emocional, o estudo encontra

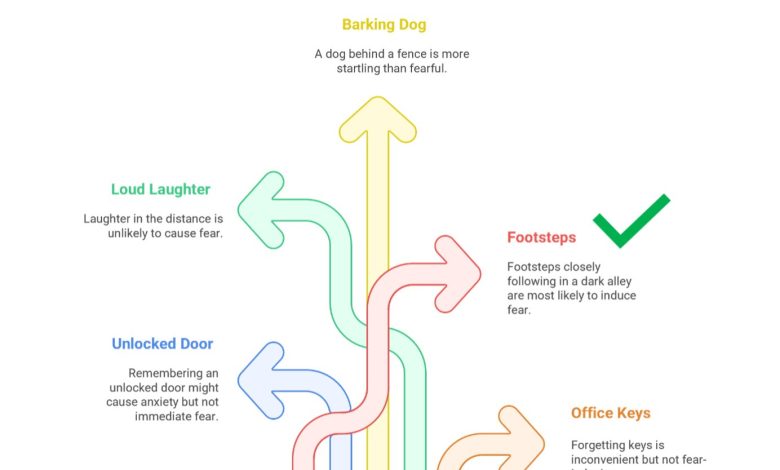

Imagem ilustrando o tipo de cenário usado em testes de inteligência emocional, juntamente com breves explicações que avaliam o raciocínio emocional por trás de cada resposta. Crédito: Katja Schlegel.

Ao longo de suas vidas, os humanos podem estabelecer conexões sociais significativas com outras pessoas, empatia com elas e compartilhando suas experiências. A capacidade das pessoas de gerenciar, perceber e entender as emoções experimentadas por si e pelos outros é amplamente chamada de inteligência emocional (EI).

Nas últimas décadas, os psicólogos desenvolveram vários testes projetados para medir a EI, que normalmente avaliam a capacidade das pessoas de resolver problemas relacionados à emoção que eles podem encontrar em suas vidas cotidianas. Esses testes podem ser incorporados a várias avaliações psicológicas empregadas em pesquisas, ambientes clínicos, profissionais e educacionais.

Pesquisadores da Universidade de Bern e da Universidade de Genebra realizaram recentemente um estudo que avalia a capacidade de grandes modelos de idiomas (LLMS), as técnicas de aprendizado de máquina sustentando a funcionalidade de agentes de conversação como o ChatGPT, para resolver e criar testes de EI. Suas descobertas, publicadas em Psicologia de Comunicaçõessugere que os LLMs possam resolver esses testes quase tão bem quanto os seres humanos e podem ser ferramentas promissoras para o desenvolvimento de futuros testes psicométricos de EI.

“Estou pesquisando a EI há muitos anos e desenvolvi vários testes baseados em desempenho para medir a capacidade das pessoas de reconhecer, entender e regular com precisão as emoções em si mesmas e nos outros”, disse Katja Schlegel, primeiro autor do artigo, ao Medical Xpress.

“Quando o ChatGPT e outros grandes modelos de idiomas se tornaram amplamente disponíveis e muitos de meus colegas e eu começamos a testá -los em nosso trabalho, parecia natural perguntar: como esses modelos se apresentariam nos testes de EI que criamos para os seres humanos? Ao mesmo tempo, um debate científico e animado está se desenrolando se a IA pode realmente possuir o empatio – a capacidade de entender, compartilhar e compartilhar e se desenrolar e se desenrolarem.

EI e empatia são dois conceitos intimamente ligados, pois ambos estão associados à capacidade de entender as experiências emocionais dos outros. Schlegel e seus colegas Nils R. Sommer e Marcello Mortillaro decidiram explorar até que ponto os LLMs poderiam resolver e criar problemas relacionados à emoção nos testes de EI, pois isso também poderia oferecer alguma indicação do nível de empatia que possuem.

Para conseguir isso, eles pediram a seis LLMs amplamente utilizados para completar cinco testes de EI que foram originalmente projetados para seres humanos como parte das avaliações psicológicas. Os modelos que eles testaram incluíram ChatGPT-4, Chatgpt-O1, Gemini 1.5 Flash, Copilot 365, Claude 3.5, Haiku e Deepseek V3.

“Os testes de EI que usamos apresentam cenários emocionais curtos e solicitam a resposta mais inteligente emocionalmente, como identificar o que alguém provavelmente está sentindo ou a melhor forma de gerenciar uma situação emocional”, explicou Schlegel. “Comparamos então as pontuações dos modelos com as médias humanas de estudos anteriores”.

Imagem mostrando a porcentagem de respostas corretas nos cinco testes de EI para cada um dos LLMs testados. Crédito: Katja Schlegel.

Na segunda parte de seu experimento, os pesquisadores pediram ao ChatGPT-4, uma das versões mais recentes do ChatGPT lançado ao público, para criar versões totalmente novas dos testes de EI usados em seus experimentos. Esses testes devem incluir diferentes cenários emocionais, perguntas e opções de resposta, além de especificar quais são as respostas corretas às perguntas.

“Em seguida, demos os testes originais e gerados pela IA a mais de 460 participantes humanos para ver como as duas versões se comparam em termos de dificuldade, clareza, realismo e quão bem eles se correlacionaram com outros testes de EI e uma medida da inteligência cognitiva tradicional”, disse Schlegel.

“Isso nos permitiu testar não apenas se os LLMs podem resolver testes de EI, mas se eles podem raciocinar sobre emoções profundamente o suficiente para criar testes válidos, o que acreditamos ser um passo importante para aplicar esse raciocínio em configurações mais abertas e do mundo real”.

Notavelmente, Schlegel e seus colegas descobriram que os LLMs que testaram tiveram um bom desempenho em todos os testes de EI, atingindo uma precisão média de 81%, o que é maior que a precisão média alcançada pelos entrevistados humanos (56%). Seus resultados sugerem que os LLMs existentes já são muito melhores para entender o que as pessoas podem sentir em diferentes contextos, pelo menos quando se trata de situações estruturadas como as descritas nos testes de EI.

“Ainda mais impressionantemente, o ChatGPT-4 conseguiu gerar itens de teste de EI totalmente novos, classificados pelos participantes humanos tão igualmente claros e realistas quanto os itens originais e mostravam uma qualidade psicométrica comparável”, disse Schlegel. “Em nossa opinião, a capacidade de resolver e construir esses testes reflete um alto nível de entendimento conceitual das emoções”.

Os resultados deste estudo recente podem incentivar os psicólogos a usar o LLMS para desenvolver testes de EI e materiais de treinamento, que atualmente são realizados manualmente e podem ser bastante demorados. Além disso, eles poderiam inspirar o uso de LLMs para gerar cenários de dramatização personalizados e outros conteúdos para o treinamento de assistentes sociais.

“Nossas descobertas também são relevantes para o desenvolvimento de agentes sociais, como chatbots de saúde mental, tutores educacionais e avatares de atendimento ao cliente, que geralmente operam em contextos emocionalmente sensíveis, onde entender as emoções humanas é essencial”, acrescentou Schlegel.

“Nossos resultados sugerem que o LLMS, no mínimo, pode imitar as habilidades de raciocínio emocional que servem como um pré-requisito para tais interações. Em nossos próximos estudos, planejamos testar o desempenho do LLMS em menos estruturas e de conversas emocionais da vida real, além do formato controlado dos itens de teste.

Mais informações:

Katja Schlegel et al, grandes modelos de linguagem são proficientes na solução e criação de testes de inteligência emocional, Psicologia de Comunicações (2025). Doi: 10.1038/s44271-025-00258-x.

© 2025 Science X Network

Citação: Modelos de idiomas grandes se destacam na criação e solução de testes de inteligência emocional, o estudo descobre (2025, 4 de junho) recuperado em 4 de junho de 2025 de https://medicalxpress.com/news/2025-06-large-language-excel-emotional-intelligence.html

Este documento está sujeito a direitos autorais. Além de qualquer negociação justa para fins de estudo ou pesquisa particular, nenhuma parte pode ser reproduzida sem a permissão por escrito. O conteúdo é fornecido apenas para fins de informação.