IA identifica milhares de casos de violência doméstica tratados como “acidentes” nos hospitais

Tânia Rêgo / Agência Brasil

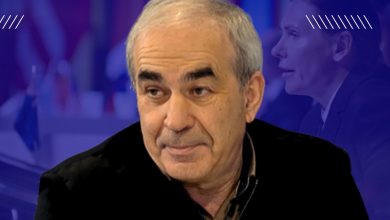

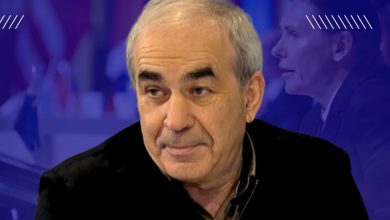

Um “detetive de IA” faz uma coisa muito simples: dá-se-lhe um bloco de texto e ele diz-nos se a lesão aí descrita tem probabilidade de ter origem violenta ou não.

A violência por vezes esconde-se à vista de todos, sobretudo numa urgência hospitalar movimentada.

Entre o caos de equipas cansadas e sobrecarregadas e a relutância das vítimas em falar, a violência baseada no género e as agressões em geral passam muitas vezes despercebidas.

Um novo sistema de Inteligência Artificial, desenvolvido em Itália, pretende agora colmatar essa falha e, nos primeiros testes, já identificou milhares de lesões que os profissionais de saúde do país tinham rotulado incorretamente.

O projeto é um esforço interdisciplinar que envolve a Universidade de Turim, a unidade local de saúde ASL TO3 e o Hospital Mauriziano. A coordenação está a cargo de Daniele Radicioni, professor associado de Ciência de Computadores na Universidade de Turim.

“O nosso sistema faz uma coisa muito simples: dá-se-lhe um bloco de texto e ele diz-nos se a lesão aí descrita tem probabilidade de ter origem violenta ou não”, explicou Radicioni à ZME Science.

A equipa teve acesso a um conjunto de dados muito vasto: 150 mil registos de urgência do Istituto Superiore di Sanità (ISS) e mais de 350 mil do Hospital Mauriziano.

O objetivo era ensinar o computador a ler as “notas de triagem” — as avaliações clínicas presenciais redigidas por enfermeiros e médicos. O sistema não recorre a imagens médicas: trabalha apenas com essas notas.

O problema é que estas notas são desorganizadas. Variam de hospital para hospital e estão cheias de abreviaturas, gralhas e jargão clínico. Para as interpretar, os investigadores treinaram várias arquiteturas de IA, incluindo um modelo personalizado chamado BERTino.

O BERTino foi pré-treinado especificamente para a língua italiana. É mais leve e mais rápido do que modelos de grande escala, como o GPT, o que o torna adequado para computadores hospitalares com recursos limitados.

Ao contrário de sistemas mais antigos, que normalmente se limitam a procurar palavras-chave, como “murro” ou “bater”, este modelo utiliza o que os cientistas chama de “mecanismo de atenção”: analisa a estrutura da frase no seu conjunto para compreender o contexto, distinguindo, por exemplo, entre “atingida por um carro” (acidente) e “atingida pelo parceiro” (violência).

Um fosso nos dados

No início do estudo, os investigadores repararam numa discrepância estranha. Na base de dados nacional (ISS), cerca de 3,6% das lesões eram assinaladas como violentas. Mas, no Hospital Mauriziano, em Turim, esse valor caía a pique para apenas 0,2%.

Seria Turim uma cidade muito mais segura — ou estaria algo a escapar?

Era um bom terreno de teste. A equipa aplicou a IA a quase 360 mil registos do hospital classificados como “não violentos”, para perceber se o algoritmo detetava o que os humanos não tinham detetado.

Os resultados foram inquietantes: o sistema assinalou 2.085 registos como potencialmente violentos. Quando os investigadores os analisaram manualmente, confirmaram que 2.025 correspondiam, de facto, a lesões resultantes de violência.

“O Hospital Mauriziano trabalha de forma muito eficaz na prevenção”, disse Radicioni. “Por isso, os números baixos podem dever-se ao facto de alguma violência ter sido evitada.”

Ainda assim, persiste uma subdeteção e subnotificação da violência, dizem os autores do estudo. Essa subdeteção é particularmente frequente na violência doméstica.

Notoriamente difícil de identificar

De acordo com os dados mais recentes do Instituto Nacional de Estatística de Itália (ISTAT), apenas 13,3% das mulheres que sofrem violência a denunciam, e essa percentagem desce para 3,8% quando o agressor é o parceiro atual.

As mulheres raramente revelam a violência sofrida às mãos dos companheiros, por poderem depender financeiramente deles, temer represálias ou sentir vergonha. Podem também recear ser culpabilizadas — um problema que continua a ser significativo em muitos países.

Para além de detetar a violência, a Inteligência Artificial mostrou potencial para identificar quem a causou. Numa tarefa separada, o modelo tentou classificar o agressor, distinguindo entre parceiro, familiar ou ladrão.

A IA distingue quem provocou a lesão tratando a “previsão do agressor” como uma tarefa de classificação independente.

Depois de um registo ser identificado como violento, o modelo volta a analisar o texto para atribuir o agressor a uma de oito categorias específicas. Se a nota disser “agredida pelo marido”, o sistema associa-o à categoria Cônjuge/Parceiro. Se o texto descrever um roubo, classifica o agente como Ladrão.

Pode parecer que isto não acrescenta nada de novo, mas a IA encontrou casos que estavam assinalados como “não violentos”, mesmo quando o texto escrito na triagem continha indícios claros de violência.

Se a nota disser: “Doente caiu pelas escadas”, mas a pessoa foi na realidade empurrada e não contou a ninguém, a IA não tem forma de o detetar. Mas se a nota disser: “Doente refere agressão pelo marido” e, ainda assim, o caso tiver sido rotulado como “acidente”, então a IA deteta-o.

Este tipo de erro acontece com uma frequência surpreendente.

Identificar a origem da lesão é crucial, porque a violência física é um forte indicador de escalada. “A grande maioria das mulheres que acabam por ser mortas já tinha ido anteriormente ao serviço de urgência por episódios de violência”, sublinha Radicioni. Identificar estes casos cedo pode, literalmente, salvar vidas.